SEO의 관문 Robots.txt 역할과 사용 방법

목차

1. 소개

Robots.txt 파일은 검색 엔진 크롤러에게 웹 사이트의 페이지 인덱싱 규칙을 알려주는 중요한 파일입니다. 이 기사에서는 SEO에 관한 Robots.txt 파일의 역할과 사용 방법에 대해 알아보겠습니다.

2. Robots.txt의 역할

Robots.txt 파일은 다음과 같은 역할을 수행합니다:

- 검색 엔진 크롤러에게 웹 사이트의 페이지 인덱싱 규칙을 알려줍니다.

- 특정 디렉토리나 파일을 크롤링하지 않도록 지시할 수 있습니다.

- 크롤러가 접근할 수 있는 페이지를 제한하거나 허용할 수 있습니다.

- 검색 크롤러에 의한 과부하 방지를 합니다.

- 사이트 맵 위치 전달 하여 웹마스터도구에 등록되지 않은 다양한 검색엔진에게 위치를 알려줄 수 있습니다.

3. Robots.txt 사용 방법

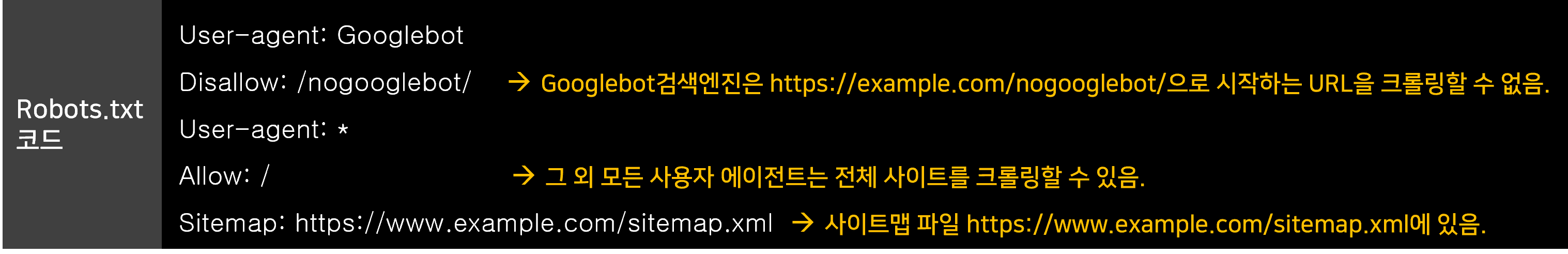

Robots.txt 파일의 사용 방법은 다음과 같습니다:

- 파일을 웹 사이트의 루트 디렉토리에 저장합니다.

- Allow 및 Disallow 지시문을 사용하여 특정 경로나 파일을 크롤러에게 허용하거나 제한합니다.

- User-agent 지시문을 사용하여 특정 크롤러에 대한 규칙을 설정할 수 있습니다.

- Sitemap 지시문을 사용하여 사이트맵의 위치를 알려줄 수 있습니다.

4. 사례 연구 및 통계

Robots.txt 파일의 사용이 SEO에 미치는 영향을 확인하기 위해 다음과 같은 사례 연구와 통계를 살펴볼 수 있습니다:

- 사례 연구 1: 회사 X는 Robots.txt 파일을 사용하여 중요한 페이지를 크롤러에게 허용함으로써 검색 엔진에서의 가시성을 향상시켰습니다.

- 사례 연구 2: 웹 사이트 Y는 Robots.txt 파일을 사용하여 크롤러가 접근할 수 없는 디렉토리를 설정함으로써 중복 컨텐츠 문제를 해결하고 검색 엔진에서의 순위를 향상시켰습니다.

- 통계 1: Robots.txt 파일을 사용하는 웹 사이트는 검색 엔진 크롤러의 효율성을 높일 수 있으며, 이는 검색 엔진에서의 노출과 트래픽 증가로 이어질 수 있습니다.

- 통계 2: 올바르게 구성된 Robots.txt 파일은 웹 사이트의 SEO 성과를 향상시킬 수 있습니다. 특히 중복 컨텐츠와 같은 문제를 예방할 수 있습니다.

5. 결론

Robots.txt 파일은 SEO에 있어서 중요한 역할을 수행합니다. 올바르게 구성된 Robots.txt 파일은 검색 엔진 크롤러가 웹 사이트를 효율적으로 크롤링하고 인덱싱할 수 있도록 도와줍니다. 사례 연구와 통계를 통해 Robots.txt 파일의 사용 방법과 이점을 확인하였으며, 웹 사이트의 SEO를 개선하기 위해 Robots.txt 파일을 적절하게 활용하는 것이 권장됩니다.

SEO에 대한 다양한 추가글 들을 읽어보세요.

- 카페24, 메이크샵, 고도몰 제대로 된 사이트맵 만들기 (2024년 7월 9일)

- SEO 마스터: 내부 링크로 검색 순위 올리기 (2024년 7월 3일)

- SEO 최적화를 위한 내부 링크 구축 전략 (2024년 7월 3일)

- 카페24 사이트 네이버 웹마스터도구로 성공적 등록하기 (2024년 6월 26일)

- AI 기반 SEO 최적화: 최신 기술을 활용한 검색 엔진 대응법 (2024년 6월 26일)

- SEO와 네이버 서치 어드바이저: 블로그 트래픽 폭발시키기 (2024년 6월 26일)

- 쇼핑몰 홈페이지 제작 시 SEO 최적화 필수 팁 (2024년 6월 24일)

- 효율적인 워드프레스 SEO 설정으로 검색 순위 올리기 (2024년 6월 24일)

- 워드프레스 SEO 최적화로 검색엔진 상위 노출하기 (2024년 6월 24일)

- 유튜브 키워드 분석을 통한 SEO 최적화 꿀팁 대공개 (2024년 6월 24일)

- 효과적인 메타태그 작성으로 검색 노출 극대화하기 (2024년 6월 24일)

- 워드프레스와 헤드리스 CMS의 SEO 비교 (2024년 6월 23일)

- 2024년 seo 최적화 전략 (2024년 6월 23일)

- 검색엔진 1위 목표! 성공적인 SEO 전략 비법 (2024년 6월 23일)

- 초보자를 위한 워드프레스와 SEO 통합 가이드 (2024년 6월 23일)

- 블로그 키워드 검색, 직접 해보니 달라진 점 (2024년 6월 23일)

- 진정성 있는 블로그 글쓰기 비법 (2024년 6월 23일)

- 구글 서치 콘솔로 SEO 최적화하는 법 (2024년 6월 23일)

- 콘텐츠 전략으로 검색결과 페이지 장악하기 (2024년 6월 23일)

- 효과적인 SEO 업체 선택 가이드 (2024년 6월 23일)

- 구글과 네이버 SEO 변화: 2024년 마케팅 인사이트 (2024년 6월 23일)

- 네이버 검색엔진최적화(SEO) 최신 트렌드 분석 (2024년 6월 23일)

- 자동 사이트맵 생성기 추천 (2024년 6월 15일)

- 워드프레스 솔루션의 seo 최적화 설정 및 전략 (2024년 5월 28일)

- 구글 AMP와 SEO의 상관관계 이해하기 (2024년 5월 28일)

- SEO 도구 활용법: 상위 랭킹 비법 (2024년 5월 28일)

- 구조화 데이터와 SEO의 상관관계 (2024년 5월 28일)

- 콘텐츠 마케팅과 SEO의 상호 연관성 (2024년 2월 28일)

- 디지털 마케팅의 기본 검색엔진최적화(SEO)에 대해서 (2024년 1월 29일)

- 홈페이지(웹사이트) 구조와 검색엔진최적화(SEO) (2024년 1월 29일)

- 검색엔진최적화 전문가란? (2024년 1월 29일)

- 워드프레스에 최적화된 웹호스팅 서비스 비교 분석 (2024년 1월 25일)

- SSR 서버사이드렌더링의 원리와 SEO에 미치는 영향 (2024년 1월 24일)

- 2024년도 최신 seo 최적화 방법론은? (2024년 1월 14일)

- 네이버, 빙 인덱스 나우 등록 방법 총정리 – 실시간 검색엔진등록 지원 (2024년 1월 12일)

- 점점 더 중요해지는 타켓 오디언스 공감&가치 중심 콘텐츠 마케팅 (2024년 1월 7일)

- 현금 없는 결제 보편화가 어떻게 마케팅 전략에 영향을 미치는가? (2024년 1월 7일)

- 다이렉트 및 레퍼럴 트래픽 전략이란? (2024년 1월 7일)

- 왜 링크드인은 B2B 마케터에게 중요한 플랫폼으로 부상하는가? (2024년 1월 7일)

- 짧고 간결한 숏폼콘텐츠의 인기요인은? (2024년 1월 7일)

- MZ 세대에게 인기 있는 마케팅 전략인 팝업스토어란? (2024년 1월 7일)

- 마케팅 및 영업에서 생성형 AI를 활용하는 방법은? (2024년 1월 7일)

- 챗봇과 같은 AI 기술을 활용한 마케팅이 증가하고 있는데 현황은? (2024년 1월 7일)

- 2024년도 사용자 생성 콘텐츠 (UGC)가 중요해지는 이유는? (2024년 1월 7일)

- 2024년도 인플루언서 마케팅은 유효한가? (2024년 1월 7일)

- 구글 알고리즘 업데이트에 대처하는 SEO전략 (2024년 1월 5일)

- 최신 seo 기법에서 소셜 미디어의 중요성 (2024년 1월 5일)

- 네이버 검색엔진의 신기술 인덱스나우(indexnow)에 대해서 알아보자 (2024년 1월 5일)

- 테크니컬seo 속도 최적화에 대해 알아보자. (2024년 1월 5일)

- 웹사이트 구조 개선을 위한 SEO 최적화 방법 (2024년 1월 4일)

- seo비용에 대한 가이드를 알려드립니다. (2023년 12월 26일)

- 누구나 쉽게 하는 검색엔진최적화 방법 (2023년 12월 26일)

- 품질 좋은 백링크 확보 방법은? (2023년 12월 25일)

- 2024년도 인공지능시대 백링크 전략은 유효한가? (2023년 12월 25일)

- 2024년도 콘텐츠 seo 전략은? (2023년 12월 25일)

- 2024년 검색엔진최적화 방법 총정리 (2023년 12월 24일)

- 검색엔진최적화 목적, 방법 그리고 가이드 총정리 (2023년 12월 23일)

- 백링크란? 효과,필요성, 실행방법 (2023년 12월 23일)

- 네이버 SEO: 검색 엔진 최적화의 핵심 요소 (2023년 12월 23일)

- 구글 SEO: 검색 엔진 최적화의 핵심 전략 (2023년 12월 23일)

- SEO와 서버정보 보안의 중요성(Server명, X-Powered-By) (2023년 12월 23일)

- 구글의 새로운 SEO 룰: 코어 웹 바이탈이란? (2023년 12월 23일)

- 구글의 새로운 SEO 룰: 페이지 경험(UX)란? (2023년 12월 23일)

- 홈페이지 내부링크 활용을 통한 체류율 및 SEO 효과 극대화방안 (2023년 12월 23일)

- 구글서치콘솔 페이지속도 인사이트란? (2023년 12월 23일)

- 웹페이지 리소스 수, 다운로드 속도가 seo에 미치는 영향 (2023년 12월 23일)

- html, js, css 압축병합이 seo에 미치는 영향 (2023년 12월 23일)

- Gzip 텍스트압축은 seo에 무슨 도움이 될까? (2023년 12월 23일)

- 콘텐츠 SEO 프로세스 소개 (2023년 12월 23일)

- 쉽게 읽어보는 검색엔진최적화(SEO) 기본가이드 (2023년 12월 21일)

- 관련 키워드를 활용한 콘텐츠 최적화 (2023년 12월 19일)

- 구글과 네이버에서의 SEO 최적화 전략 비교 (2023년 12월 19일)

- SEO와 보안서버(SSL, HTTPS) 세팅 (2023년 6월 24일)

- SEO에서 스크립트 에러체크 중요성 (2023년 6월 24일)

- SEO에서 HTML5 준수의 중요성 (2023년 6월 24일)

- SEO에서 파비콘 등록의 중요성 (2023년 6월 24일)

- Chat GPT 활용 SEO카피라이팅 서비스/솔루션 (2023년 6월 12일)

- 국내 최초 SEO최적화된 블로그 솔루션 SEOBlogØ 1.0 소개 (2023년 6월 9일)

- 검색엔진에게 내 페이지 알리기: 사이트맵 (2023년 6월 9일)

- SEO의 관문 Robots.txt 역할과 사용 방법 (2023년 6월 9일)

- 구글 네이버 애널리틱스 설치와 SEO 영향 (2023년 6월 9일)

- 구글/네이버 구조화 데이터: 검색 엔진 최적화를 위한 핵심 전략 (2023년 6월 9일)

- SEO 단순 URL의 중요성 (2023년 6월 9일)

- 캐노니컬 태그 – 최적의 검색 엔진 최적화 기법 (2023년 6월 9일)

- 이미지 alt 속성 사용 시 반듯이 기억할 점은? (2023년 6월 8일)

- 2023년 최신 SEO(검색엔진최적화) 완벽가이드 (2023년 6월 7일)

- H1~H6 제목태그는 어떻게 사용해야하나요? (2023년 6월 7일)

- 검색엔진최적화의 메타태그란? (2023년 6월 7일)

- 검색엔진최적화 현지화: 글로벌 시장에서의 성공을 위한 필수 전략 (2023년 6월 6일)

- ChatGpt를 검색엔진최적화(seo)에 활용해 보자!! (2023년 2월 2일)

- 테크니컬 seo 컨설팅 프로세스(절차) (2023년 1월 18일)

- SEARCH INTENT(검색의도)란 무엇인가? (2022년 11월 9일)

- 구글 네이버/웹마스터도구 사이트맵 등록하기 (2022년 3월 3일)

- 네이버 웹마스터도구 서치어드바이저 등록, 소유확인 방법정리 (2022년 3월 1일)

- 구글서치콘솔(GSC) 연결,등록,사용법 및 대표 도메인 선정 방법 (2022년 2월 27일)

- [콘텐츠 seo 글 작성법] 검색엔진이 좋아하는 글은 어떤 글일까요? (2021년 9월 15일)

- 홈페이지(웹사이트) 기획자가 꼭 알아야 할 콘텐츠 seo 방법은? (2021년 9월 14일)

- 콘텐츠 SEO는 어떤 프로세스로 진행하나요? (2021년 9월 14일)

- 콘텐츠seo의 핵심&연관 키워드란 무엇일까요? (2021년 9월 14일)